序章: 強化学習の基本概念

強化学習とは

強化学習(Reinforcement Learning, RL)は、エージェントが環境との相互作用を通じて報酬を最大化するための行動を学習する機械学習の一分野です。

エージェントは行動を選択し、その結果に基づいて報酬を受け取ります。このプロセスを繰り返すことで、エージェントは最適な行動方針(ポリシー)を学習します。

強化学習の基本構造

強化学習は以下の要素で構成されます:

- エージェント(Agent): 環境と相互作用する主体。

- 環境(Environment): エージェントが行動する場。

- 状態(State, S): 環境の現在の状況。

- 行動(Action, A): エージェントが取る行動。

- 報酬(Reward, R): エージェントが行動の結果として受け取るフィードバック。

マルコフ決定過程(MDP)

強化学習問題はしばしばマルコフ決定過程(Markov Decision Process, MDP)として定式化されます。

MDPは以下の要素で構成されます:

- 状態空間(State Space, S)

- 行動空間(Action Space, A)

- 遷移確率(Transition Probability, P)

- 報酬関数(Reward Function, R)

MDPの基本的な前提は、次の状態が現在の状態と行動にのみ依存するというマルコフ性です。

1: ベルマン方程式と動的計画法

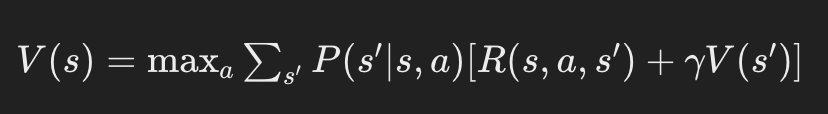

ベルマン方程式

ベルマン方程式は、強化学習の中心的な概念の一つです。

これは、特定の状態における価値をその状態から始まる将来の報酬の期待値として定義します。

ここで、V(s) は状態 s の価値、P(s′∣s,a) は状態 s から行動 a を取ったときに次の状態が s′ になる確率、R(s,a,s′) は報酬、γ は割引率です。

動的計画法

動的計画法(Dynamic Programming, DP)は、ベルマン方程式を解くための方法の一つです。

DPには主に2つのアプローチがあります:

- 方策反復法(Policy Iteration): 方策を固定して価値関数を計算し、その後方策を改善するプロセスを繰り返します。

- 価値反復法(Value Iteration): 価値関数を直接更新し、方策を導出します。

2: モデルフリー強化学習

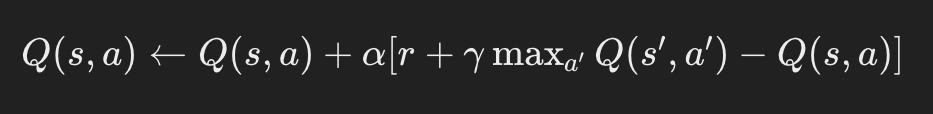

Q学習

Q学習はモデルフリー強化学習の代表的な手法です。

モデルフリーとは、環境の遷移確率や報酬関数を知らなくても学習ができることを意味します。

Q学習では、Q値(行動価値関数)を更新します。

ここで、α は学習率、r は即時報酬、s′ は次の状態です。

サンプル効率とオフポリシー学習

Q学習はオフポリシー学習の一例です。

これは、エージェントが実際に取った行動とは異なる行動方針(ターゲットポリシー)を学習できることを意味します。

この特性により、サンプル効率が高くなります。

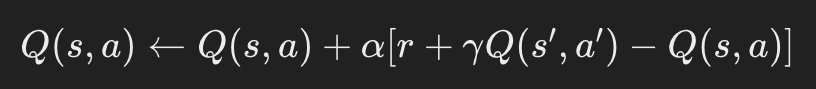

SARSA

SARSA(State-Action-Reward-State-Action)は、オンポリシー学習の一例です。これは、エージェントが実際に取った行動に基づいてQ値を更新します。

SARSAはエージェントが実際に取る行動に基づくため、Q学習に比べてより安全なポリシーを学習する傾向があります。

3: 方策勾配法

方策勾配法の基本

方策勾配法(Policy Gradient Methods)は、直接方策(ポリシー)をパラメータ化し、そのパラメータを勾配上昇法によって最適化します。

エージェントの方策は確率的であり、行動を選択する確率を学習します。

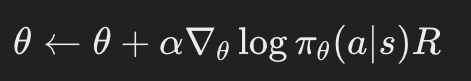

REINFORCEアルゴリズム

REINFORCEは最も基本的な方策勾配アルゴリズムです。

このアルゴリズムでは、エピソード全体の報酬に基づいて方策のパラメータを更新します。

ここで、θ は方策のパラメータ、πθ(a∣s) は行動 a を状態 s で選択する確率、R はエピソード全体の報酬です。

方策勾配の欠点と改良

方策勾配法は直接方策を学習するため、連続行動空間にも適用可能です。しかし、勾配の分散が大きいため、学習が不安定になることがあります。これを改善するために、以下の手法が提案されています:

- アクタークリティック法(Actor-Critic Methods): アクター(方策)とクリティック(価値関数)を別々に学習し、勾配の分散を減らす。

- 先行利得法(Advantage Actor-Critic, A2C): クリティックによって計算された先行利得(Advantage)を使用して、更新を安定化。

4: 深層強化学習

深層Qネットワーク(DQN)

深層Qネットワーク(Deep Q-Network, DQN)は、ディープラーニングとQ学習を組み合わせた手法です。

DQNでは、ニューラルネットワークを使用してQ値を近似します。

経験再生とターゲットネットワーク

DQNの成功の鍵は、経験再生(Experience Replay)とターゲットネットワーク(Target Network)の導入です。

- 経験再生: エージェントの経験をメモリに保存し、ランダムサンプリングによって学習データを得ることで、データの相関を減らし、学習を安定化。

- ターゲットネットワーク: Q値を計算するためのターゲットネットワークを一定間隔で更新し、学習の安定性を向上。

深層強化学習の応用

深層強化学習は、ゲームプレイ、ロボティクス、自動運転など、多くの実世界の問題に応用されています。

これらの応用により、DQNやその拡張手法(Double DQN、Dueling DQN、Prioritized Experience Replayなど)が広く研究されています。

5: 強化学習の最新動向

マルチエージェント強化学習

マルチエージェント強化学習(Multi-Agent Reinforcement Learning, MARL)は、複数のエージェントが協力または競争する環境で学習する手法です。

これにより、エージェント間の相互作用を考慮した複雑な問題を解決することができます。

転移学習とメタ強化学習

転移学習(Transfer Learning)とメタ強化学習(Meta-Reinforcement Learning)は、異なるタスク間で学習した知識を活用する手法です。

これにより、新しいタスクに対する学習効率を向上させることができます。

強化学習とゲーム理論

ゲーム理論と強化学習の統合は、特に競争環境や戦略的相互作用が重要な領域で注目されています。

ナッシュ均衡や進化的ゲーム理論の概念を活用することで、より洗練されたエージェント行動を設計することが可能です。

まとめ

強化学習は、エージェントが環境との相互作用を通じて報酬を最大化するための強力な機械学習手法です。

基本的な理論から最新の応用まで、多岐にわたる分野で研究が進められています。

ベルマン方程式や動的計画法、モデルフリー強化学習、方策勾配法、深層強化学習など、多くの手法とその応用例が存在します。

また、マルチエージェント強化学習や転移学習など、最新の研究動向も注目されています。

ChatGPTの影響もあり、画像認識や自然言語処理に目が行きがちな最近のAI動向ですが、強化学習もこの二つに負けないくらいのトピックであるのと同時に、思っている以上にさまざまな活用がされている分野ということもあり、筆者としてはこれからさらにこの分野も社旗進出をし日の目を浴びる時が来ると考えており、その日も遠くはないと考えています。